Im Interview mit Hendrik Lösch, Softwarearchitekt bei ZEISS Digital Innovation

Nachhaltigkeit bedeutet, heute schon an Morgen zu denken – das betrifft nicht nur die Gesellschaft, sondern auch Unternehmen und nicht zuletzt die Industrie. Die Digitalisierung nimmt dabei eine Doppelrolle ein, denn sie birgt sowohl Chancen als auch Herausforderungen für eine nachhaltige Zukunft. Einerseits ermöglicht sie effizientere Prozesse, Ressourcenschonung und den Zugang zu neuen Technologien. Andererseits bringt sie auch ökologische Belastungen durch den steigenden Energieverbrauch und die zunehmende Nachfrage nach digitalen Infrastrukturen mit sich.

Im nachfolgenden Interview sprechen wir mit Hendrik Lösch, Softwarearchitekt bei ZEISS Digital Innovation. Er ist Experte auf dem Gebiet und beschäftigt sich bereits seit einigen Jahren mit ressourceneffizienter Softwareentwicklung. Jüngst hat er als Autor am Leitfaden des Bitkom „Ressourceneffizienz im Software Lifecycle“ mitgewirkt.

Im Gespräch werden wir erfahren, welche Auswirkungen der Softwareentwicklungsprozess auf die Nachhaltigkeitsziele von Unternehmen haben kann und wie wichtig es ist, Nachhaltigkeit von Beginn an in die digitale Planung zu integrieren.

Hendrik, du verwendest lieber den Begriff Ressourceneffizienz statt Nachhaltigkeit, warum?

Ressourceneffizienz ist konkreter und messbarer als der breite Begriff der Nachhaltigkeit. Nachhaltigkeit beinhaltet ein umfassendes Konzept mit ökologischen, sozialen und wirtschaftlichen Dimensionen. Ressourceneffizienz hingegen beschäftigt sich mit dem gezielten Einsatz von Ressourcen und ist daher praxisorientierter. Es lassen sich daraus klarere Handlungsschritte ableiten, die sowohl ökologische als auch wirtschaftliche Vorteile bringen, ohne mit der Komplexität des gesamten Nachhaltigkeitsbegriffs zu überfordern.

Welche konkreten Ressourcen umfasst das Thema in der Softwareentwicklung und wo überall können Ressourcen eingespart werden?

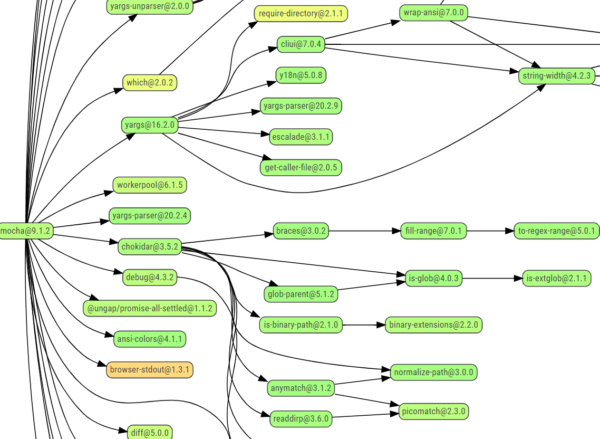

Die hauptsächlich betrachteten Ressourcen sind die eingesetzte Energie und Hardware. Alle anderen lassen sich darauf reduzieren bzw. lassen sie sich aus ihnen ableiten. Tauschen wir bspw. Hardware vorzeitig aus, schlägt sich dies sowohl finanziell als auch ökologisch nieder. Finanziell lässt sich dies leicht über die notwendigen Investitionskosten quantifizieren, ökologisch ist es etwas schwieriger, da hierfür das eingesetzte CO2-Äquivalent berücksichtigt werden muss, welches in der bestehenden und neu angeschafften Hardware gebunden ist.

Ähnlich verhält es sich mit den übertragenen und verarbeiteten Daten. Je mehr Daten wir verarbeiten, desto mehr Energie und Hardware benötigen wir. Wobei diese Aussage etwas missverständlich ist: Denn die Betrachtungen zielen nicht nur auf die schiere Menge an übertragenen Daten und die dafür benötigte Rechenleistung ab. Im Rahmen der ressourceneffizienten Softwareentwicklung geht es insbesondere darum, Wege aufzuzeigen, wo im Lebenszyklus von Software angesetzt werden kann, um schlankere und effizientere Lösungen auf den Weg zu bringen. Sei es in der Entwicklung selbst, im Softwaretest aber auch im Betrieb und in der Wartung.

Warum lohnt es sich frühzeitig mit Nachhaltigkeitsaspekten auseinanderzusetzen und Maßnahmen zu ergreifen?

Der Entwicklungsprozess einer digitalen Lösung lässt sich vereinfacht in folgende Aufgabenbereiche unterteilen: Auftragsklärung, Konzeptarbeit sowie Entwicklung und Betrieb. Im ersten Schritt, der Auftragsklärung, ermöglicht die dort eingenommene übergeordnete Perspektive die Grundsatzfrage nach dem Ressourcenverbrauch unmittelbar in die Vision zu integrieren.

In der Praxis kommt dies zu kurz, wenn man sich nur die Frage stellt, was eine Software leisten muss, aber nicht, wie sie diese Leistung erbringen soll. So beobachte ich immer wieder, dass Projekte in Auftrag gegeben werden, die vorrangig niedrige Entwicklungskosten im Blick haben und welche anschließend aufgrund ineffizienter Ressourcennutzung unnötig hohe Betriebskosten aufweisen. Betrachtet man also bereits bei der Auftragsklärung die zu erwartenden Gestehungskosten, beeinflusst dies die Konzeptarbeit und führt automatisch zu einer effizienteren Umsetzung und einem günstigeren Betrieb. Ein niedriger CO2-Fußabdruck ist in diesem Fall dann eher ein erfreulicher Nebeneffekt, der sich automatisch einstellt.

Du hast an einem Leitfaden des Bitkom mitgewirkt. Was möchtest du damit erreichen, was ist deine Motivation?

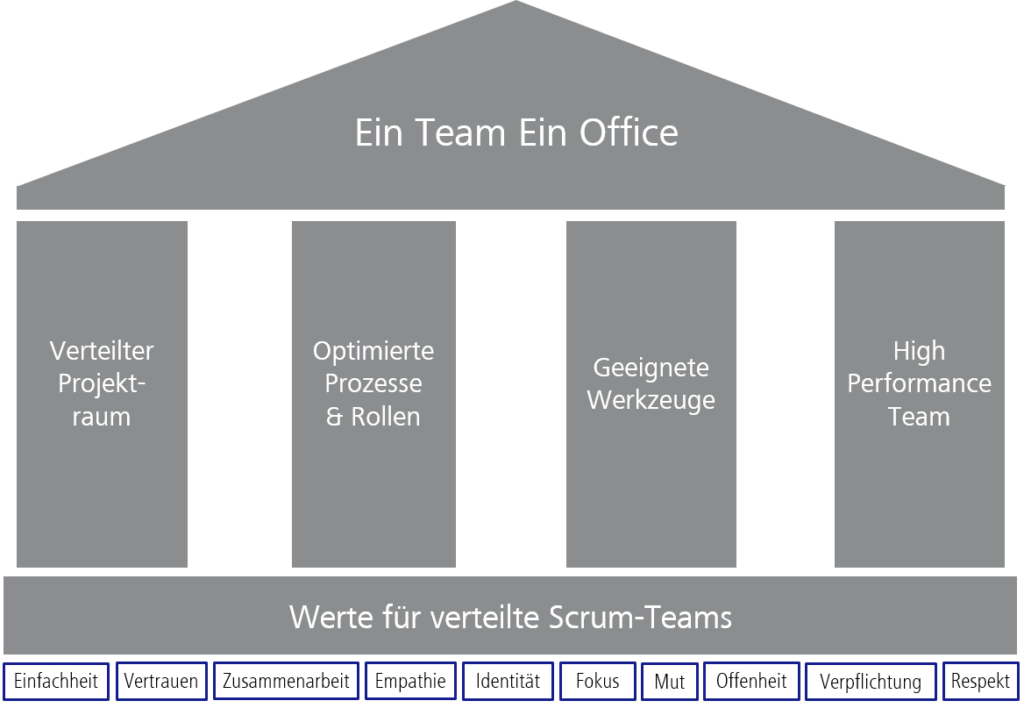

Wie zuvor erwähnt, teilt sich der Entstehungsprozess der Software in verschiedene Aufgabenbereiche auf. In der Realität sind diese nicht selten mit unterschiedlichen Denkmustern und Arbeitsrealitäten der jeweiligen Beteiligten verbunden. Man könnte salopp sagen: Sales verkauft, Architekten entwerfen, Entwickler bauen, Tester testen und die IT betreibt. Die Frage nach der Nachhaltigkeit einer Software wird somit für jeden dieser Bereiche anders beantwortet, wobei sich die Antworten verstärkend aufeinander auswirken.

Wird in der Auftragsklärung nicht einmal über Nachhaltigkeitsaspekte gesprochen, können diese beim Entwurf nur bedingt berücksichtig werden und somit auch nicht zu nachhaltigen Lösungen führen. Die Kosten dieser Verschwendung treten dann aber verstärkt im Betrieb auf, wo sie als gegeben akzeptiert werden.

Die drei Teile des Leitfadens sollen genau diesen Weg darstellen und zeigen, wie vielschichtig und komplex die Zusammenhänge sind. Es gibt unzählige Ansatzpunkte, um Ressourcen und damit Kosten einzusparen, langfristig stabil und somit in sich selbst nachhaltig wird das Vorgehen aber erst, wenn man es interdisziplinär umsetzt. Wir haben daher absichtlich die jeweiligen Zielgruppen in eigenen Leitfäden adressiert, um in ihrer Sprache und ihren Problemfeldern, allgemeine Maßnahmen zu skizzieren, die bei der Schaffung ressourceneffizienter Lösungen helfen sollen.

Der Leitfaden spricht von interdisziplinärer Zusammenarbeit als Schlüssel. Wen braucht es, um ressourceneffiziente digitale Lösungen zu entwickeln?

Zunächst müssen natürlich alle Beteiligten für das Thema sensibilisiert sein. Requirements Engineers, Product Owner und Softwarearchitekten haben aber den entscheidendsten Einfluss. Requirements Engineers und Product Owner sind maßgeblich an der Auftragsklärung beteiligt und arbeiten eng mit den Stakeholdern zusammen, um die Anforderungen zu ermitteln und eine klare Produktvision zu formulieren. Sie müssen kontinuierlich die Auswirkungen der geäußerten Anforderungen hinterfragen und verstehen, wie diese Anforderungen miteinander interagieren.

Softwarearchitekten hingegen sind dafür verantwortlich, Lösungen basierend auf diesen Anforderungen zu entwerfen. Sie müssen den Auftraggebern auch Rückmeldungen zu den Anforderungen geben und das Bewusstsein für deren Auswirkungen über die rein funktionale Ebene hinaus schärfen. Ihre Verantwortung endet nicht mit dem Entwurf; sie unterstützen die Entwickler bei der Umsetzung und müssen die technische Vision des Produkts vor schädlichen Einflüssen schützen. Dazu gehört auch die enge Zusammenarbeit mit Testern und dem Betrieb, um das tatsächliche Verhalten der digitalen Lösung zu überprüfen und zu ermitteln, wie sich der Ressourcenverbrauch in der Praxis darstellt.

Welche Herausforderungen siehst du bei der Umsetzung nachhaltiger Praktiken in der Softwareentwicklung?

Gerade die Bewegung der „Sustainable Software“ bzw. „Green Software“ zielte in der Vergangenheit eher auf die Reduktion des CO2-Fußabdrucks von Software ab. Dies ist ein immens wichtiges Thema, hat aber auch das Problem, dass CO2-Einsparung für kaum ein Unternehmen ein aktiver Business Driver ist. Allerdings verändert sich diese Situation allmählich durch die steigenden Stromkosten und die CO2-Bepreisung. Letztere ermöglicht es, ökologische Kosten in ökonomische umzuwandeln und sie somit in einen primären Treiber zu überführen. Diese Bepreisung ist politisch bedingt und stark umstritten, was zu einer Investitionsunsicherheit führt. Daher fällt es Unternehmen oft schwer, entsprechende Einsparmaßnahmen zu ergreifen.

Hinzu kommt, dass viele Technologien, die wir einsetzen, extra dafür entwickelt wurden, Komplexität zu verbergen. Gerade das Cloud Computing ist hier ein sehr gutes Beispiel. Mit wenigen Klicks können Sie eine Lösung aufbauen, die weltweit skaliert. Fehlendes Bewusstsein bzgl. des realen Ressourceneinsatzes führt dann dazu, dass Lösungen komplexer gebaut werden, als sie es möglicherweise sein müssten. Die ökologischen Auswirkungen lagert man dann zwar an den Cloud-Anbieter aus, bezahlt sie aber mit, über wiederum gesteigerte Wartungsaufwände und Betriebskosten. Da diese Zusammenhänge sehr abstrakt sind und die Betrachtungen der Betriebskosten oft nachträglich geschehen, werden diese schnell als gegeben angesehen und dann auch in kommenden Projekten nicht ausreichend berücksichtigt, wodurch eine Kostenkaskade entstehen kann.

Wo muss deiner Meinung nach noch ein Umdenken geschehen, um das Bewusstsein zu schärfen und die Herausforderungen zu überwinden?

Aus der Perspektive nachhaltiger Softwareentwicklung ist es entscheidend, sowohl die Ökologie als auch die Ökonomie im Auge zu behalten, um langfristig stabile und kosteneffiziente Lösungen zu entwickeln. Dieses Zusammenspiel ist jedoch oft sehr abstrakt, weshalb es schwer zu vermitteln ist und die tatsächlichen Kostentreiber schwer zu ermitteln sind. So wollte ich mit meinen vorangegangenen Aussagen bspw. nicht den Eindruck erwecken, dass die Cloud etwas Schlechtes sei. Sie ist ein hervorragendes Werkzeug, dass aufgrund seiner Flexibilität und des eingebauten Monitorings viele Möglichkeiten bietet, nur die Ressourcen zu verbrauchen, die auch wirklich gebraucht werden. Man muss sich aber dieser Möglichkeiten und des eigenen Bedarfs bewusst sein, um wirklich nachhaltig zu arbeiten.

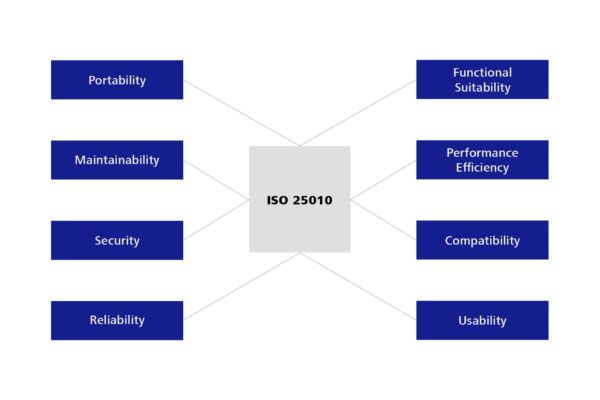

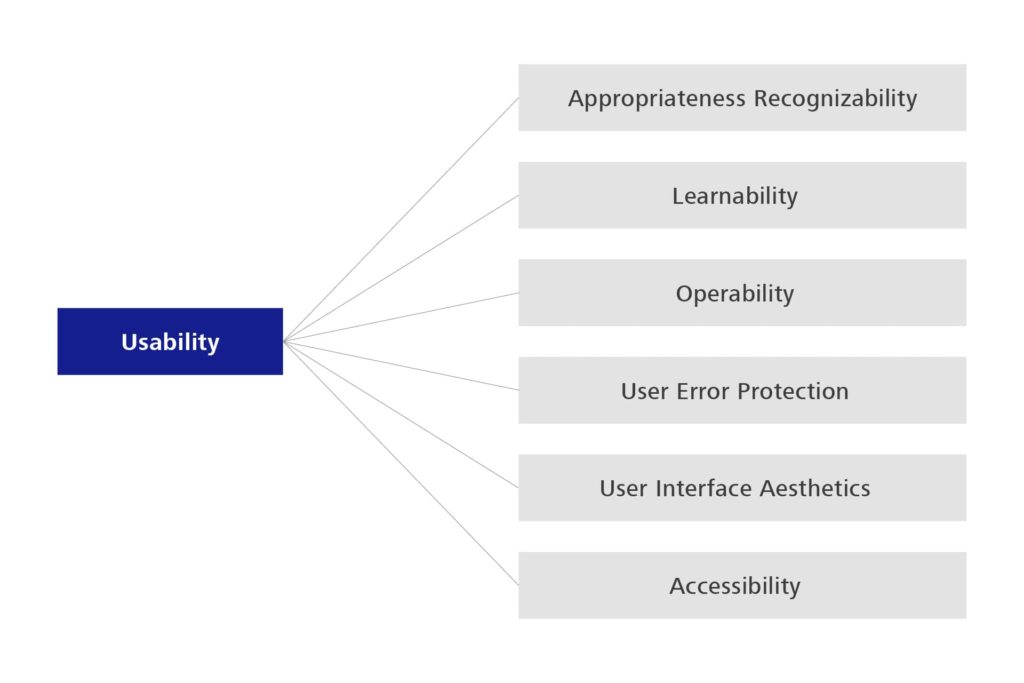

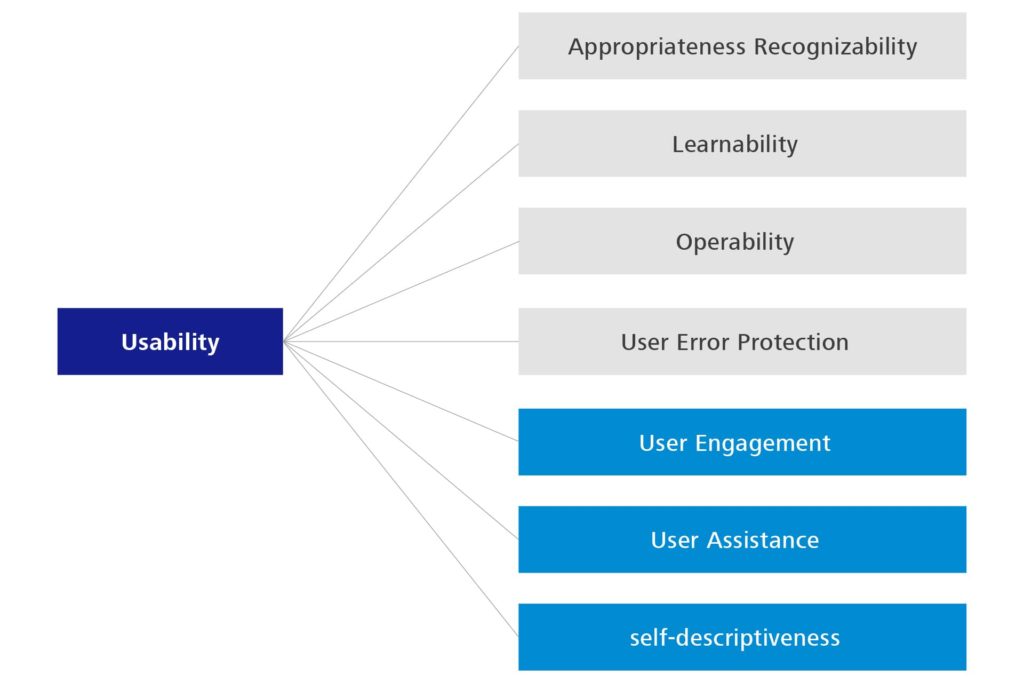

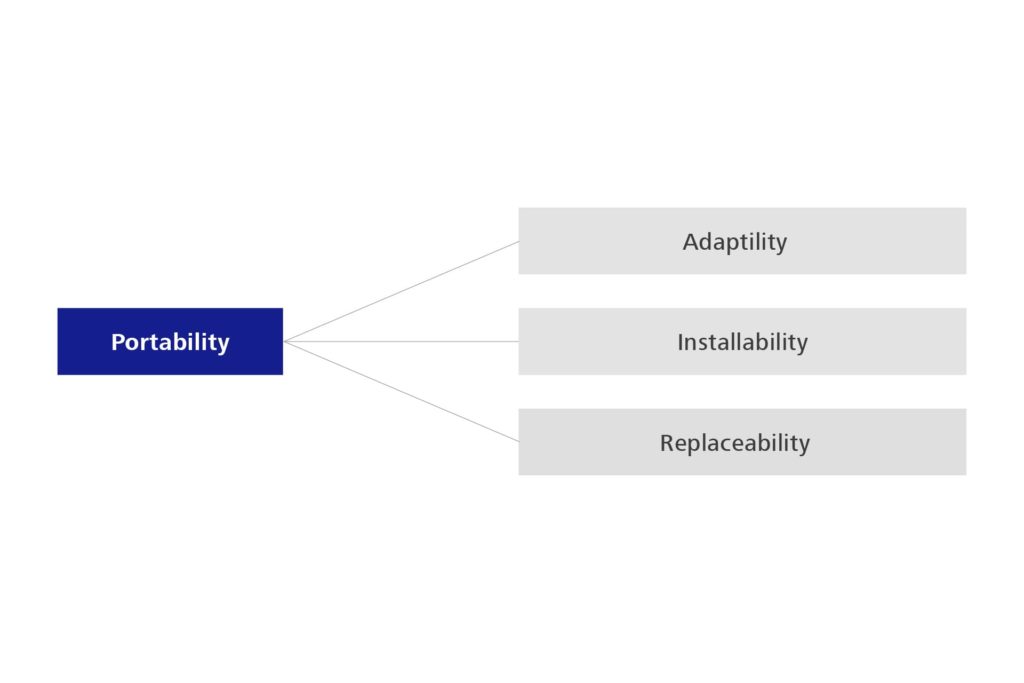

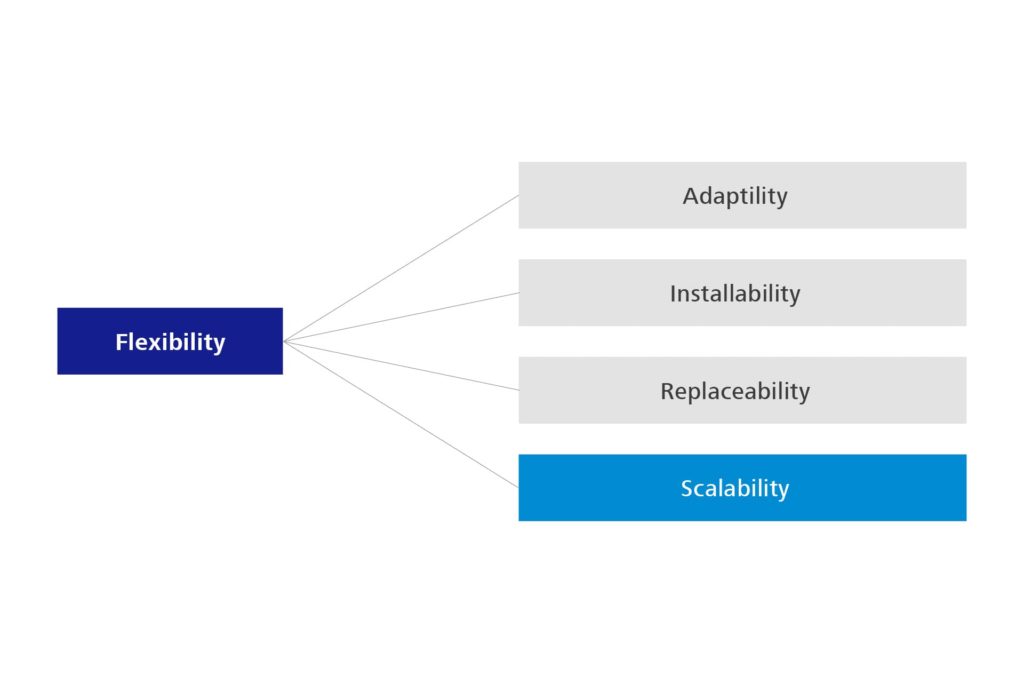

Unternehmen können dieser Problematik begegnen, indem sie sich in allen Phasen des Softwareentwicklungsprozesses an der ISO 25000 orientieren und allen Beteiligten klar kommunizieren, unter welchen Bedingungen die betrachteten Systeme funktionieren sollen. Nur so können Programmierer Lösungen entwickeln, die in einem angemessenen Rahmen Ressourcen verbrauchen und somit unnötige Kosten, unabhängig von ihrer Art, vermeiden. Statt also nach völlig neuen Theorien zu suchen, reicht es oft schon, bestehenden Theorien korrekt zu folgen und langfristig orientiertes Handeln, statt kurzfristiger Einsparungen zu belohnen.

Wie siehst du die Zukunft der Softwareentwicklung in Bezug auf Nachhaltigkeit? Welche Trends werden in den nächsten Jahren entscheidend sein?

Die Einsparung von CO2-Äquivalenten ist nach wie vor ein sehr wichtiges Thema, wird aber aufgrund der veränderten Weltlage überschattet und zunehmend durch weitere Themen angereichert. Hierzu zählt die Einbeziehung ökonomischer Aspekte und Betrachtungen zur Resilienz sowie Souveränität.

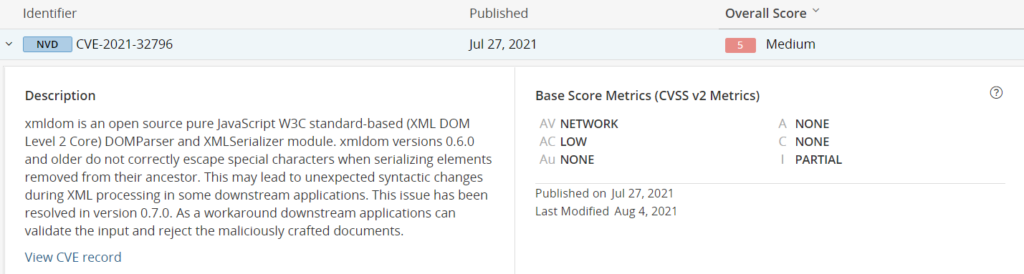

Resilienz wird aufgrund steigender Cyberkriminalität und vermehrt auftretender digitaler Störaktion immer wichtiger, da deren Auswirkungen für Unternehmen existenzbedrohend werden können. Souveränität ist wiederum bedeutend, da sie die Unabhängigkeit von digitalisierten Lösungen und den mit ihnen verbundenen Entscheidungsprozessen beeinflusst. Nicht zuletzt aufgrund der politischen Entwicklung in den USA sorgen sich europäische Unternehmen wieder vermehrt darum, inwieweit sie selbst oder ihre externen Dienstleister die eigentliche Hoheit über die entstehenden digitalen Systeme und damit verbundenen Daten haben.

Ganz deutlich sehe ich dies zum Beispiel daran, dass unsere Kunden sich vermehrt darauf konzentrieren ihre bestehenden Systeme zu optimieren, statt Neuentwicklungen zu starten.

Inwiefern spielt die Ressourceneffizienz bei diesen Trends eine Rolle?

Sie wirkt verstärkend auf die Bestrebungen und gibt vielfältige Hinweise zu möglichen Lösungsansätzen. Nehmen wir beispielsweise die Datensparsamkeit. Dies ist ein Konzept, welches sowohl im Kontext der Ressourceneffizienz als auch Souveränität und Sicherheit von Softwaresystemen eine Rolle spielt. Im Grundgedanken sollten wir möglichst nur die Daten erfassen, die wir auch effektiv verarbeiten können und die einen nachweislichen Mehrwert für unsere Kernprozesse darstellen. Je weniger Daten wir erfassen, desto weniger Aufwand haben wir, sie zu speichern, verwalten und abzusichern. Dies führt nicht nur zu einer Reduzierung des Energieverbrauchs, sondern minimiert auch potenzielle Sicherheitsrisiken und erleichtert die Einhaltung von Datenschutzbestimmungen.

Welche praktischen Tipps würdest du Unternehmen geben, die ihre Softwareentwicklung und den daran anknüpfenden Betrieb nachhaltiger gestalten möchten?

Ressourceneffizienz ist kein neuer Begriff und auch kein kurzfristiger Trend. Es geht vielmehr darum, die richtigen Dinge auf die richtige Weise zu tun. Dazu ist es wichtig, sich darüber im Klaren zu sein, was diese „richtigen Dinge“ sind und wie man sie effektiv umsetzt.

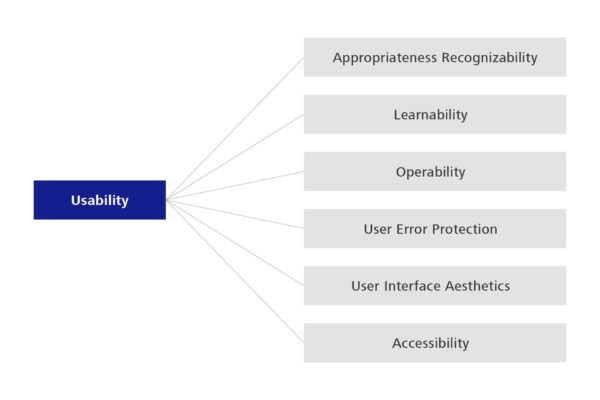

Eine der einfachsten Möglichkeiten, dies zu erreichen, besteht darin, bei Neuentwicklungen verstärkt auf Qualitätsmerkmale der Software zu achten, die über die reine Funktionalität hinausgehen. Zudem ist es entscheidend, mögliche Betriebskosten bereits detailliert in der Auftragsklärung und im Entwurf zu berücksichtigen, um die Lösungen an den tatsächlichen Bedarf anzupassen.

Diese Überlegungen lassen sich auch auf bestehende Systeme anwenden, wobei Änderungen hier oft aufwändiger und schwerer zu rechtfertigen sind. Es sei denn, es sind signifikante Einsparungen zu erwarten. Diese Einsparungen müssen schließlich den Aufwand für die erforderlichen Änderungen ausgleichen. Angesichts der typischen Lebensdauer von Business-Software sind aber zumindest die Kosten für eine solche Analyse überschaubar. Dem zuvor erwähnten Leitfäden kann man einige der Aspekte entnehmen, auf die man achten sollte.