Die moderne industrielle Produktion erfordert eine Erweiterung und Digitalisierung der klassischen Produktionsflusssteuerung, wenn Intelligenz und Vernetzung ermöglicht werden sollen. Dabei ist es notwendig, alle Ebenen der Automatisierungspyramide mithilfe von digitalen Lösungen und Datenverarbeitungssystemen zu verbinden und zu integrieren.

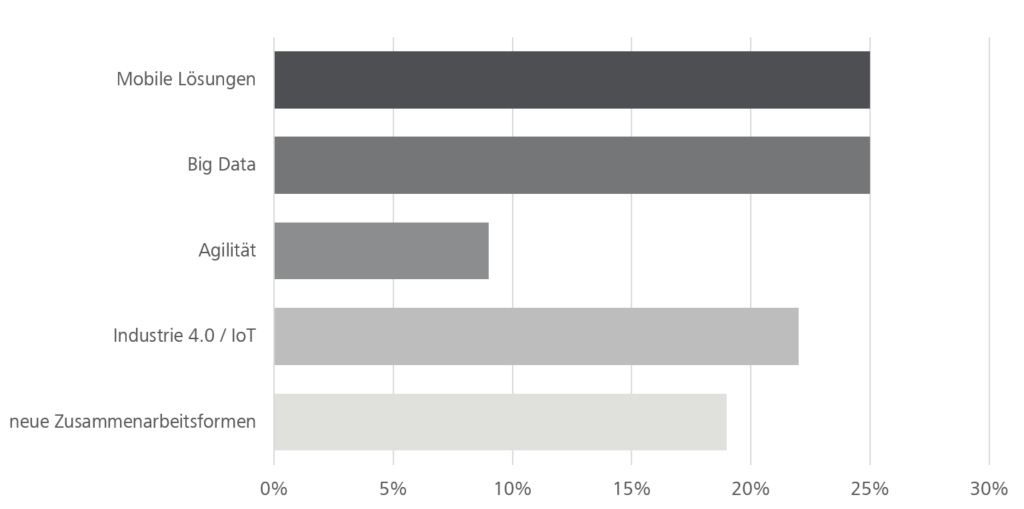

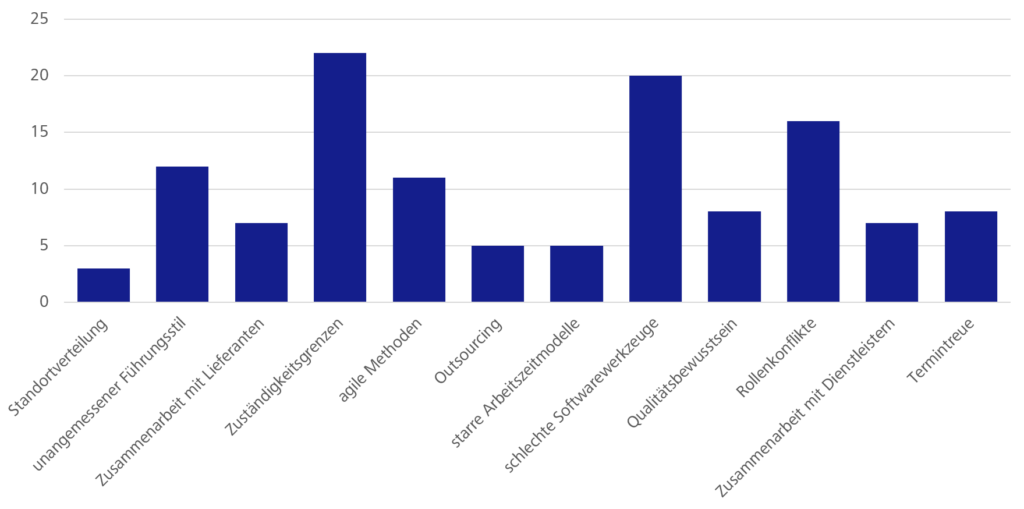

In der heutigen Zeit gibt es zahlreiche neue Technologien, wie Künstliche Intelligenz, Digital Twins oder Argumented Reality, die für eine smarte Produktion der Zukunft immer wichtiger werden. Um diese innovativen Methoden zum Einsatz zu bringen, ist eine Anbindung an vorhandene Systeme notwendig, was jedoch bisher nur eingeschränkt möglich ist. Eine standardisierte Herangehensweise zur Bereitstellung von Daten für den Einsatz Künstlicher Intelligenz oder zur Erstellung von Digitalen Zwillingen fehlt beispielsweise. Auch neue Anwendungsfälle, wie Vorausschauende Wartung, erfordern einen individuellen Zugriff auf die benötigten Daten. Nur durch enge Zusammenarbeit zwischen den Abteilungen und mit einer klaren Strategie für die Integration können neue Technologien und deren Anwendung erfolgreich umgesetzt werden.

Machbarkeit im Brownfield

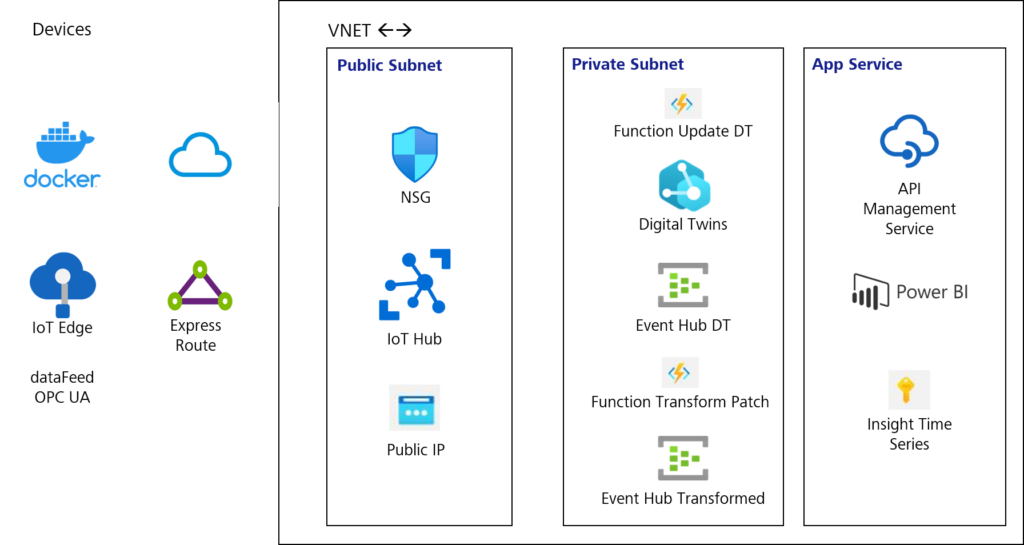

Die meisten digitalen Transformationsprojekte finden in Brownfield-Produktionsumgebungen statt. Das bedeutet, dass die Fertigungsanlagen bereits in Betrieb sind und es aus wirtschaftlicher Sicht notwendig ist, Lösungen zu finden, die mit den vorhandenen Maschinen und Softwaresystemen integriert werden können. Die Entwicklung hin zu einer smarten Produktion benötigt neue Austauschkanäle, die eine dritte Dimension des Datenflusses eröffnen und es ermöglichen, vorhandene Daten zentral zur Verfügung zu stellen. Dabei ist es unwirtschaftlich, diese neuen Kanäle mit jedem Projekt neu zu implementieren. Es empfiehlt sich ein generischer Ansatz, bei dem Daten Anwendungsfall-unabhängig aus den jeweiligen Produktionssystemen geladen und homogen bereitgestellt werden. Eine zentrale Datenplattform, auf der alle vorhandenen Produktionsinformationen zugänglich gemacht werden, ermöglicht einen unabhängigen, flexiblen und skalierbaren Weg für die Weiterentwicklung und Optimierung der Produktionsprozesse.

Vorteile der zentralen Datenplattform

- Demokratische Bereitstellung vorhandener Maschinendaten aus dem Brownfield

- Schnelle Anbindung neuer Technologien

- Umsetzung innovativer Anwendungsfälle

- Einfache Umsetzung von Datentransparenz und Data Governance

- Zugriff auf historische Daten und Echtzeitdaten

- Skalierbare Anwendungsentwicklung

- Erhöhte Effizient und Qualität beim Datentransfer

Herausforderungen der Datenverarbeitung

Es gibt definierte Schnittstellen für einzelne Systeme, die beispielsweise das Auslesen von Daten aus ERP oder MES-Systemen problemlos ermöglichen. Bei einem SCADA-System sieht es jedoch anders aus, da dieses sehr heterogen und domainspezifisch aufgebaut ist. Die Schnittstellen sind hier, sowie auch bei den untergeordneten Maschinensteuerungen (SPS), nicht einheitlich definiert.

Use case

| Unser Beispiel zeigt einen klassischen induktiven Sensor, bei dem in den meisten Fällen nur das Signal „Sensor Ein/Aus“ genutzt wird. Die folgenden Funktionen sind bereits werksseitig implementiert und könnten zusätzlich ausgewertet werden: |

- Schaltermodus

- Schaltzyklus Zähler, Zähler zurücksetzen

- Betriebsstundenzähler

- Absorption (analoger Messwert des elektrischen Feldes)

- Innentemperatur

- Geräteinformationen

- Anwendungsspezifische Kennung, Anlagenkennung, Standortcode

Unabhängig vom vorhandenen Austauschkanal gibt es auf allen Ebenen Herausforderungen im Zusammenhang mit Daten. Beispiele sind Datenschutz, geschaffene Datensilos, die Verarbeitung von Massendaten, die Interaktion zwischen Mensch und Maschine oder auch nicht vorhandene oder standardisierte Kommunikationskanäle.

Angesichts der sehr heterogenen Infrastruktur in der Fertigung können individuell auf die Bedingungen angepasste Lösungen Abhilfe schaffen und sich den spezifischen Herausforderungen auf den einzelnen Ebenen widmen. Daten-Governance und -sicherheit sowie Cybersicherheit sind dabei berücksichtigt.

Ganzheitlicher Ansatz

Für die optimale Verkettung von Informationen und die damit verbundenen Vorteile, wie effiziente Ressourceneinsatz, Produktivitäts- und Qualitätssteigerung, sind nicht nur die Daten der Produktionsflusssteuerung relevant. Unternehmen haben eine Vielzahl von Parametern zu berücksichtigen:

Einsatz- und Wartungsplanung, Lagerhaltung, Personalverfügbarkeiten und vieles mehr. Die logische Verknüpfung dieser Daten ist größtenteils nur manuell möglich. Durch die Verfügbarkeit all dieser Informationen in digitaler Form könnte jedoch viel Zeit eingespart werden. Die Komplexität dieses Themas und die sehr unterschiedlichen Voraussetzungen einzelner Produktionsumgebungen machen deutlich, dass Standardlösungen nicht genügen, um den optimalen Weg hin zu einer uneingeschränkten Datenverfügbarkeit und somit zu neuen Technologien zu ebnen. Wichtig ist es also, sich zunächst mit den Anwendungsfällen auseinanderzusetzen, die den größten Mehrwert schaffen.

Die Vision für mehr Effizienz, Flexibilität und Qualität

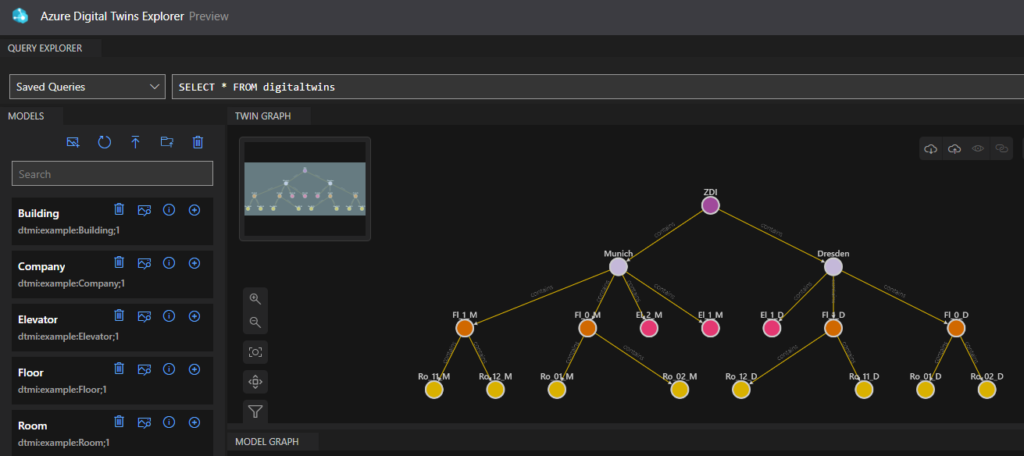

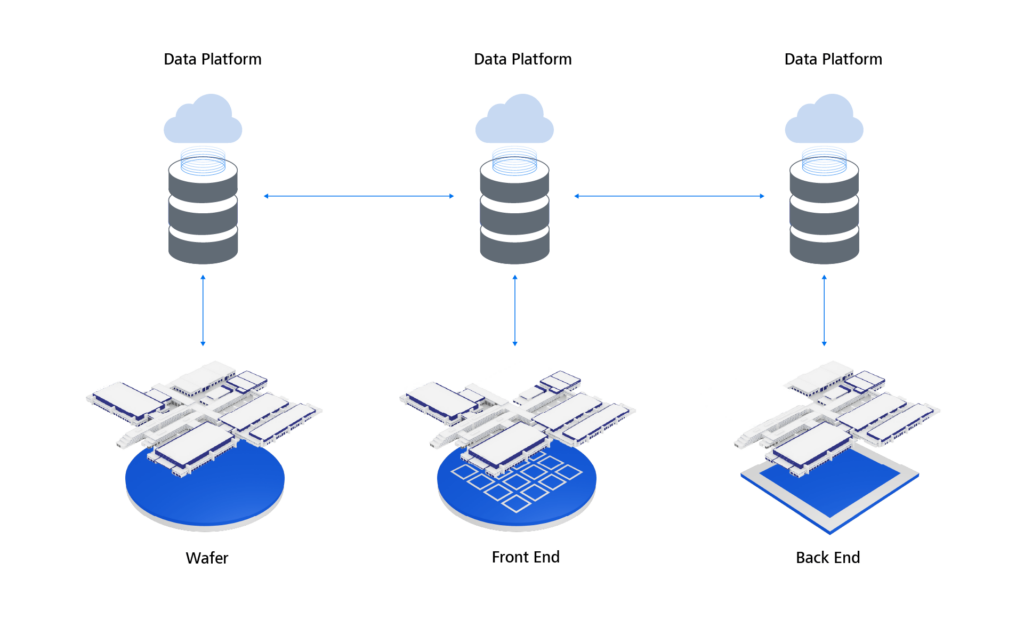

Eine umfassende Werk-zu-Werk-Kommunikation zur Verbesserung der Produktionsabläufe und zur Ursachenerkennung bei Qualitätsproblemen kann durch eine zentrale Datenplattform realisiert werden. Dabei können bereitgestellte Daten über standardisierte Schnittstellen werksübergreifend ausgetauscht werden. Dieser voll automatisierte Informationsaustausch hat zahlreiche positive Effekte auf die Produktion. Die Produktionsplanung und -steuerung kann flexibel auf Informationen von Zulieferern und Kunden reagieren. Durch Echtzeitdaten werden Engpässe und Probleme schneller erkannt und behoben. Auch Qualitätsabweichungen lassen sich werksübergreifend auf ihre Ursache zurückführen und wiederkehrende Probleme durch frühzeitige Anomalieerkennung vermeiden. Der Datenaustausch ermöglicht es zudem, Transport- und Logistikkosten zu reduzieren. Die direkte Kommunikation zwischen den Werken verbessert auch die Zusammenarbeit: Durch den Austausch von Wissen und Erfahrungen können neue Ideen und Innovationen entstehen, die die Produktion weiter verbessern.

Werksübergreifende Kommunikation in der Halbleiter- und Automobilproduktion

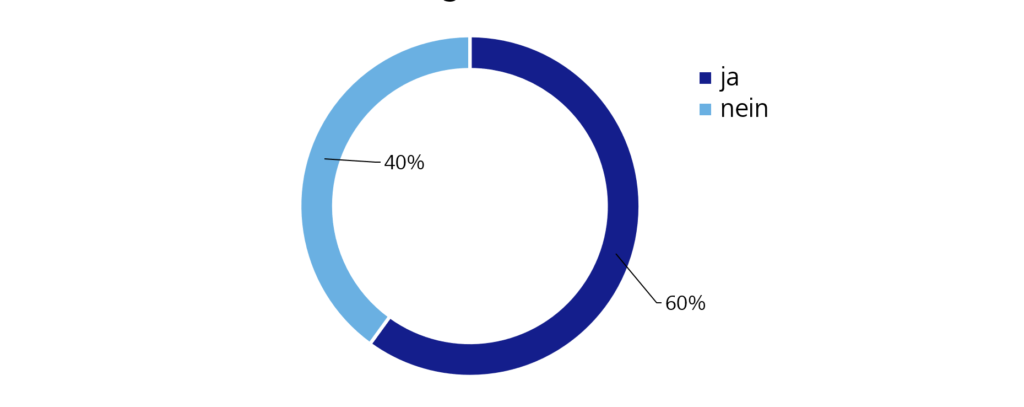

Reifegrad der Datenplattform

Wie eingangs beschrieben bildet die Verfügbarkeit von Daten die Basis für zukünftige Technologien. Eine zentrale Datenplattform ermöglicht diesen Zugang. Der tatsächliche Mehrwert entsteht, wenn die erfassten Daten genutzt und in der Produktion sinnvoll eingesetzt werden können. Dazu müssen Anwendungen an die Plattform angebunden werden, die dies ermöglichen.

Ein Zukunftsszenario beschreibt einen einheitlichen Datenspeicher, auf den sämtliche Applikationen über unterschiedliche Produktionen hinweg zugreifen. Durch die Nutzung der Datenplattform können sich die

Applikationen untereinander austauschen und weitere Speicherorte werden obsolet.

Bei einer Entscheidung für die Transformation hin zu einer zentralen Datenplattform empfehlen wir, iterativ vorzugehen und in einer geeigneten Geschwindigkeit Kommunikationskanäle und Systeme weiterzuentwickeln. Der Vorteil einer individuellen Softwareentwicklung besteht darin, dass diese sich gemäß den Voraussetzungen und Anforderungen des jeweiligen Unternehmens mitentwickelt und somit immer die nötige Balance zwischen Evolution und Revolution gehalten werden kann. Im ersten Schritt beginnen wir demnach meist mit dem Data Engineering. Wir

berücksichtigen aber auch zukünftige Anwendungsfälle in unserer Architektur und bedenken diese in der Weiterentwicklung.

Fazit

Die Zusammenführung von Daten aus verschiedenen Schichten der Automatisierungspyramide und anderen Datensilos auf einer homogenen Plattform ermöglicht es Unternehmen, ihre Daten vollständig zu demokratisieren und zu transformieren. Regeln zur Datenverwaltung helfen dabei, die Datenqualität und -sicherheit zu gewährleisten. Ein Cloud-basierter Ansatz bietet dabei viele Vorteile, wie Skalierbarkeit und Flexibilität. Durch die Nutzung einer zentralen Datenplattform sind Unternehmen in der Lage, ihre Daten effektiver zu nutzen und ihr volles Potenzial auszuschöpfen.

Weitere Informationen finden Sie in unserem Whitepaper: Industrial Data Platform