Während immer mehr Startups, Mittelständler und Großkonzerne die Digitalisierung und Vernetzung für den Ausbau ihres Geschäfts nutzen und dabei auch völlig neuartige Geschäftsmodelle entwickeln, wächst der weltweite Bedarf an Standardisierung und Umsetzungskompetenz. So haben sich aus ehemaligen Worthülsen wie „Big Data“, „Internet of Things“ (IoT) und „Industrie 4.0“ längst konkrete Technologien entwickelt, die den digitalen Wandel vorantreiben und Unternehmen bei der Steigerung ihrer Produktivität, der Optimierung von Lieferketten und letztlich der Erhöhung von Rohertragsmargen unterstützen. Dabei profitieren sie vor allem von den wiederverwendbaren Diensten der sogenannten Hyperscaler wie Amazon, Microsoft, Google oder IBM, sind aber oft selbst nicht in der Lage, die Implementierung maßgeschneiderter Lösungen mit eigenem Personal zu stemmen. Die ZEISS Digital Innovation (ZDI) begleitet und unterstützt als Partner und Entwicklungsdienstleister ihre Kunden bei der digitalen Transformation.

Cloud-Lösungen hatten es lange Zeit vor allem im industriellen Umfeld schwer, da es weit verbreitete Vorbehalte in Bezug auf Daten-, IT- und Anlagensicherheit wie auch Entwicklungs- und Betriebskosten gab. Zudem erforderte die Anbindung und Aufrüstung unzähliger heterogener Bestandssysteme viel Fantasie. Inzwischen sind diese Grundsatzfragen weitgehend geklärt und Cloud-Anbieter werben mit spezifischen IoT-Diensten um neue Kunden aus dem produzierenden Gewerbe.

Um die typischen Chancen und Herausforderungen von IoT-Umgebungen möglichst praxisnah illustrieren zu können, wird ein interdisziplinäres ZDI-Team – bestehend aus erfahrenen Expertinnen und Experten aus den Bereichen Business-Analyse, Software-Architektur, Frontend- und Backend-Entwicklung, DevOps-Engineering sowie Testmanagement und Testautomatisierung – in bewährter agiler Vorgehensweise einen Demonstrator entwickeln, anhand dessen später auch kundenspezifische Anforderungen auf Umsetzbarkeit geprüft werden können.

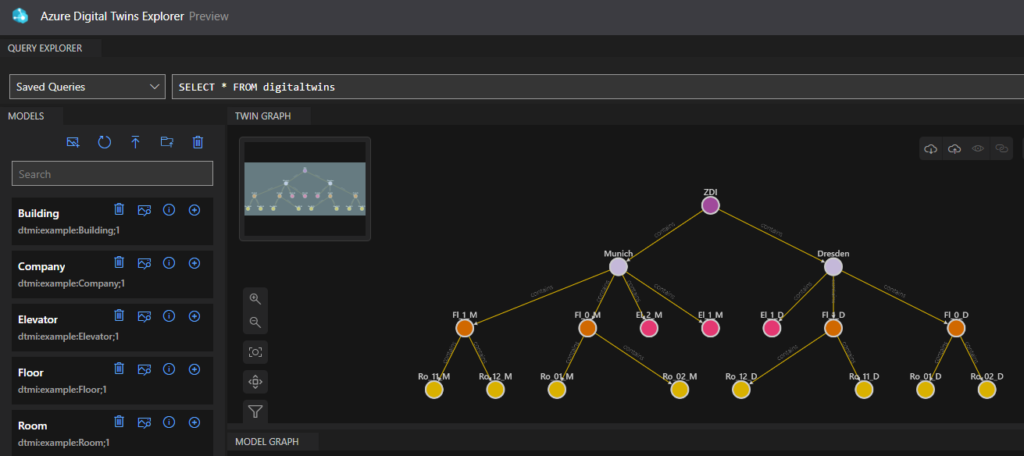

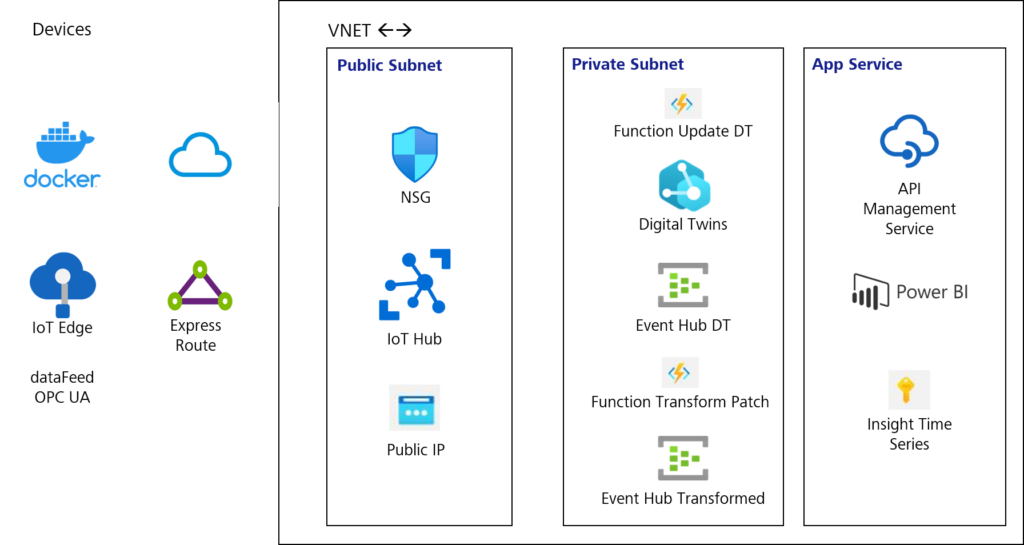

Im Demonstrator wird eine vernetzte Produktionsumgebung mithilfe einer fischertechnik Lernfabrik simuliert und mit einer selbst entwickelten Cloud-Anwendung gesteuert. Die Lernfabrik enthält mit unterschiedlichen Sensoren, Kinematiken, Fördertechnik und insbesondere einer Siemens S7 Steuerung viele typische Elemente, wie sie auch in echten Industrieanlagen zum Einsatz kommen. Über etablierte Standards wie OPC UA und MQTT werden die Geräte an ein ebenfalls integriertes IoT-Gateway angebunden, das die gesammelten Daten seinerseits über eine einheitliche Schnittstelle den dafür optimierten Cloud-Diensten bereitstellt. Umgekehrt lässt das Gateway unter Berücksichtigung strenger Anforderungen an die IT- und Anlagensicherheit auch steuernde Zugriffe auf die Produktionsanlagen von außerhalb der Werksinfrastruktur zu.

Das Herstellen und Absichern der Konnektivität ist nach erfolgter Inbetriebnahme für die über alle ZDI-Standorte verteilt arbeitenden Kolleginnen und Kollegen einerseits ein organisatorisches Erfordernis, andererseits handelt es sich dabei bereits um eine Kernanforderung jeder praxistauglichen IoT-Lösung mit durchaus weitreichenden Konsequenzen für die Gesamtarchitektur. Technologisch wird sich das Team zunächst auf die Cloud-Services von Microsoft (Azure) und Amazon (AWS) konzentrieren und dabei umfangreiche Erfahrungen aus anspruchsvollen Kundenprojekten im IoT-Umfeld einbringen. Weiterhin stehen Architektur- und Technologie-Reviews sowie die Implementierung erster Monitoring Use Cases im Fokus. Darauf aufbauend sind in der Folge auch komplexere Use Cases zur Taktzeitoptimierung, Maschineneffizienz, Qualitätssicherung oder Nachverfolgung (Track and Trace) geplant.

Besonders gut ist die ZDI auch im Bereich Testservices aufgestellt. Anders als in stark softwarelastigen Branchen wie z. B. der Logistik oder Finanzwirtschaft wurden die Testmanagerinnen und Testmanager in zahlreichen fertigungsnahen Use Cases jedoch immer wieder mit der Frage konfrontiert, wie Hardware, Software und insbesondere deren Zusammenspiel auf der Steuerungsebene möglichst vollumfänglich und vollautomatisch getestet werden können, ohne wertvolle Maschinen- und Anlagenzeit zu benötigen. In hyperkomplexen Produktionsumgebungen, wie sie ZEISS beispielsweise in der Halbleiter- und Automotive-Industrie vorfindet, können die ansonsten weit verbreiteten digitalen Zwillinge aufgrund schwer modellierbarer Zusammenhänge und teilweise gänzlich unbekannter Einflussfaktoren nur noch bedingt Abhilfe leisten. Umso wichtiger ist die Konzeption einer geeigneten Testumgebung, mit der Fehler eingegrenzt, reproduziert und möglichst minimalinvasiv behoben werden können.

Wir werden auf diesem Blog regelmäßig über den Projektfortschritt berichten und unsere Erfahrungen teilen.