In der heutigen digitalen Welt ist die Fähigkeit, Daten effizient und effektiv zu verwalten, von entscheidender Bedeutung für den Erfolg jeder industriellen Datenplattform. Ein zentraler Bestandteil dieses Prozesses ist die sogenannte „Data Ingestion“ oder Datenaufnahme. Aber was genau bedeutet Data Ingestion? Einfach ausgedrückt, handelt es sich dabei um den Prozess, bei dem Daten aus verschiedenen Quellen gesammelt, in eine zentrale Datenplattform übertragen und dort für die weitere Verarbeitung und Analyse gespeichert werden. In der Fertigungsindustrie spielt Data Ingestion eine besonders wichtige Rolle, da hier oft große Mengen an Daten aus unterschiedlichen Quellen zusammengeführt werden müssen. Diese Daten können beispielsweise Informationen über Produktionsprozesse, Maschinenzustände, Lieferketten und Qualitätskontrollen umfassen. Durch die Analyse dieser Daten können Unternehmen wertvolle Einblicke in Produktionsengpässe, Maschinenleistung und Produktqualität gewinnen, was zu Optimierungen in der Effizienz der Produktionsabläufe und der Reduzierung von Kosten führt.

Eine industrielle Datenplattform besteht aus mehreren Komponenten, wobei die Speicherung der Daten (Storage) eine entscheidende Funktion hat. Die Architektur einer solchen Plattform muss so gestaltet sein, dass sie die effiziente Aufnahme, Speicherung und Verarbeitung von Daten ermöglicht. Dies ist besonders wichtig, um die Performance und Skalierbarkeit der Plattform sicherzustellen.

Die Fertigungsindustrie steht vor spezifischen Herausforderungen, wenn es um die Datenaufnahme geht. Zum einen sind die Datenvolumina oft sehr hoch, da Maschinen und Sensoren kontinuierlich Daten generieren. Zum anderen stammen die Daten aus unterschiedlichen Quellen und Formaten, was die Integration erschwert. Hinzu kommen Echtzeitanforderungen, da viele Anwendungen in der Fertigung eine sofortige Verarbeitung der Daten erfordern, um beispielsweise Produktionsprozesse zu optimieren oder Ausfälle zu vermeiden.

Das Ziel dieses Artikels ist es, einen umfassenden Überblick über das Thema Data Ingestion in industriellen Datenplattformen zu geben. Im ersten Teil werden die verschiedenen Methoden und Techniken der Datenaufnahme erläutert und wir gehen auf Konzepte der Datenspeicherung ein. Wichtig ist dabei, zu verstehen, welche Vor- und Nachteile die verschiedenen Herangehensweisen haben. Im zweiten Teil diskutieren wir häufige Herausforderungen und stellen mögliche Lösungsansätze vor. Dabei legen wir besonderen Wert darauf, die Konzepte leicht verständlich zu erklären und durch konkrete Anwendungsbeispiele zu veranschaulichen.

Arten von Datenquellen in der Fertigungsindustrie

In der Fertigungsindustrie gibt es eine Vielzahl von Datenquellen, die für die Optimierung und Überwachung von Produktionsprozessen genutzt werden. Zu den wichtigsten gehören:

- Sensor- und Maschinendaten: Maschinen und Produktionsanlagen sind häufig mit Sensoren ausgestattet, die kontinuierlich Daten über Temperatur, Druck, Vibrationen und andere Betriebsparameter erfassen. Darüber hinaus generieren die Maschinen selbst auch wichtige Daten, wie z.B. Betriebszustände und Fehlermeldungen. Sowohl die Sensordaten als auch die maschinenspezifischen Daten sind entscheidend für die vorausschauende Wartung und die Optimierung der Maschinenleistung. Da die Sensordaten in vielen Fällen nicht direkt zugänglich sind, erfolgt der Zugriff häufig über die Maschinenebene, beispielsweise über eine speicherprogrammierbare Steuerung (SPS).

- SCADA-Systeme (Supervisory Control and Data Acquisition): SCADA-Systeme überwachen und steuern industrielle Prozesse auf höherer Ebene. Sie sammeln Daten von verschiedenen Sensoren und Steuergeräten und ermöglichen die Fernüberwachung und -steuerung von Produktionsanlagen.

- MES-Systeme (Manufacturing Execution Systems): MES-Systeme überwachen und steuern Produktionsprozesse in Echtzeit. Sie erfassen Daten über Produktionsaufträge, Maschinenauslastung und Produktionsqualität.

- ERP-Systeme (Enterprise Resource Planning): ERP-Systeme verwalten betriebswirtschaftliche Prozesse wie Beschaffung, Produktion, Vertrieb und Personalwesen. Sie liefern wertvolle Daten über Materialflüsse, Produktionspläne und Bestandsmanagement.

- Qualitätskontrollsysteme: Diese Systeme erfassen Daten über die Qualität der produzierten Waren. Sie helfen dabei, Qualitätsprobleme frühzeitig zu erkennen und Maßnahmen zur Verbesserung der Produktqualität zu ergreifen.

- Externe Datenquellen: Umwelt- und Wetterdaten können ebenfalls eine wichtige Rolle spielen, insbesondere in Branchen, die stark von äußeren Bedingungen beeinflusst werden. Diese Daten können genutzt werden, um Produktionsprozesse an wechselnde Umweltbedingungen anzupassen.

Datenformate

Die in der Fertigungsindustrie verwendeten Datenquellen liefern Daten in verschiedenen Formaten. Zu den gängigsten Formaten gehören:

- CSV (Comma-Separated Values): Ein einfaches Textformat, das häufig für tabellarische Daten verwendet wird. CSV lässt sich einfach mit Microsoft Excel erzeugen und verarbeiten.

- XML (Extensible Markup Language): Ein weit verbreitetes Datenformat in der industriellen Maschinenanbindung, das durch XSD (XML Schema Definition) ergänzt wird, um die Struktur und Validität der Daten präzise zu definieren. Während neuere Formate wie JSON zunehmend an Bedeutung gewinnen, bleibt XML aufgrund seiner Robustheit und Kompatibilität mit bestehender Infrastruktur weiterhin ein wichtiger Bestandteil in vielen industriellen Anwendungen.

- JSON (JavaScript Object Notation): Ein weit verbreitetes Format für strukturierte Daten, das leicht von Maschinen und Menschen gelesen werden kann.

- OPC UA (Open Platform Communications Unified Architecture): Ein plattformunabhängiges Kommunikationsprotokoll, das speziell für die industrielle Automatisierung entwickelt wurde. Besonders hilfreich sind hier genormte semantische Datenmodelle in Form von Companion Specifications.

- Bilder: In der Fertigungsindustrie werden häufig Bilddaten verwendet, beispielsweise von Kameras zur Qualitätskontrolle oder zur Überwachung von Produktionsprozessen. Diese Bilddaten können wertvolle Informationen liefern, die zur Optimierung der Produktionsabläufe beitragen.

- Dokumente: Dazu gehören Formate wie PDF, die oft technische Spezifikationen, Handbücher oder Berichte enthalten. PDF-Dokumente können zusätzlich eingebettete XML-Daten beinhalten, die strukturierte Informationen enthalten und somit die Datenanalyse erleichtern.

- Proprietäre Formate: Viele Maschinen und Systeme verwenden herstellerspezifische Datenformate, die oft speziell auf die Anforderungen der jeweiligen Anwendung zugeschnitten sind.

Datenvolumen und -geschwindigkeit

In der Fertigungsindustrie werden große Mengen an Daten generiert, die in unterschiedlichen Frequenzen und Geschwindigkeiten anfallen. Typischerweise können Sensordaten in Echtzeit oder in sehr kurzen Intervallen (Millisekunden bis Sekunden) erfasst werden, was zu einem hohen Datenvolumen führt. ERP- und MES-Systeme liefern in der Regel Daten in längeren Intervallen (Minuten bis Stunden), während Qualitätskontrollsysteme je nach Produktionszyklus variieren können.

Die Geschwindigkeit, mit der diese Daten an die zentrale Datenplattform übertragen werden, hängt von der Art der Datenquelle und den spezifischen Anforderungen der Anwendung ab. Echtzeitdaten müssen oft sofort verarbeitet werden, während andere Daten in regelmäßigen Abständen gesammelt und übertragen werden können.

Weitere Informationen zu typischen Anwendungsfällen nach Latenzbereich sind im Whitepaper Industrial Data Platform zu finden.

Datenzugriffsoptionen

Es gibt verschiedene technische Möglichkeiten, um auf die Datenquellen in der Fertigungsindustrie zuzugreifen:

- Logfiles: In einer Fertigungsanlage protokollieren Maschinen Fehlerereignisse und Betriebszeiten in Logfiles. Diese Logfiles können regelmäßig ausgelesen werden, um den Zustand der Maschinen zu überwachen und um Fehleranalysen durchzuführen.

- Dateizugriff: Ein Fertigungsunternehmen kann Sensordaten von Produktionslinien in CSV-Dateien speichern. Diese Dateien werden dann in einem zentralen Netzwerkspeicher abgelegt, wo sie von Datenanalysten abgerufen und analysiert werden können, um Produktionsmuster zu erkennen. Weitere Anwendungsgebiete für Dateizugriff sind Bilddaten oder Prüfberichte aus der Qualitätssicherung.

- SQL (Structured Query Language): Eine Produktionsdatenbank kann Informationen über Bestände, Produktionspläne und Lieferketten enthalten. Ingenieure und Datenanalysten können SQL-Abfragen verwenden, um selektiv Daten abzurufen und daraus beispielsweise spezifische Berichte zu generieren.

- CDC (Change Data Capture): Diese Technik erfasst Änderungen in Datenbanken bei ihrer Entstehung und überträgt sie an die zentrale Datenplattform. Das ist insbesondere für Anwendungsfälle interessant, bei denen sehr zeitnah (in Quasi-Echtzeit) auf Veränderungen reagiert werden soll. Damit ist eine engmaschige Überwachung von Prozessparametern und das rechtzeitige Einleiten von Gegenmaßnahmen bei erkannten Abweichungen möglich.

- API (Application Programming Interface): Viele Systeme bieten APIs an, über die Daten programmgesteuert abgerufen werden können. Ein Anwendungsgebiet ist die Integration eines Produktionsplanungssystems mit einem ERP-System, um Produktionspläne und Materialbedarfe automatisch zu synchronisieren.

- Messaging: In einer vernetzten Fertigungsumgebung kann ein MQTT-basiertes System verwendet werden, um Sensordaten von verschiedenen Maschinen an eine zentrale Steuerungseinheit zu senden. Dies ermöglicht eine Echtzeitüberwachung und Steuerung der Produktionsprozesse, was besonders in Industrie 4.0-Anwendungen wichtig ist. Apache Kafka als Lösung für die Speicherung und Verarbeitung von Datenströmen kann verwendet werden, um große Datenmengen von IoT-Geräten zu verarbeiten und zu analysieren. Es kann damit zur Optimierung von Produktionsprozessen eingesetzt werden.

Best Practices: Um die Belastung der primären Datenquelle gering zu halten, kann es sinnvoll sein, Read Replicas zu verwenden. Diese Kopien der Datenbank können für Lesezugriffe genutzt werden, ohne die Performance der Hauptdatenbank zu beeinträchtigen.

Durch die Kombination dieser verschiedenen Datenquellen, Formate und Zugriffsoptionen kann eine industrielle Datenplattform wertvolle Einblicke in die Produktionsprozesse liefern und zur Optimierung der gesamten Fertigung beitragen.

Datenspeicherung in der Plattform: Das Konzept eines Data Lakehouse

In der modernen Datenarchitektur hat sich das Konzept des Data Lakehouse als eine vielversprechende Lösung etabliert, welche die Vorteile von Data Lakes und Data Warehouse kombiniert. Ein Data Lakehouse ermöglicht die Speicherung und Verarbeitung großer Mengen an strukturierten und unstrukturierten Daten in einem einheitlichen System, was es Unternehmen erleichtert, wertvolle Erkenntnisse aus ihren Daten zu gewinnen.

Formate für die Datenspeicherung

Ein zentrales Merkmal von Data Lakehouse ist die Verwendung effizienter Speicherformate, die eine schnelle Abfrage und Analyse der Daten ermöglichen. Zu den gängigsten Formaten gehören:

- Parquet: Ein spaltenbasiertes Speicherformat, das für die Speicherung von großen Datenmengen optimiert ist. Parquet ermöglicht eine effiziente Datenkompression und -kodierung, was die Speicherkosten senkt und die Abfragegeschwindigkeit erhöht.

- Delta Lake: Eine Open-Source-Speicherlösung, die auf dem Apache Parquet Format aufbaut und ACID-Transaktionen unterstützt. Delta Lake ermöglicht es, Daten in einem Data Lake zu speichern und gleichzeitig die Vorteile eines Data Warehouse zu nutzen, indem es eine strukturierte Abfrage und Datenintegrität gewährleistet.

- Apache Iceberg: Ein weiteres Open-Source-Projekt, das eine flexible und leistungsstarke Lösung für die Verwaltung von großen Datenmengen in Data Lakehouses bietet. Iceberg unterstützt komplexe Datenabfragen und ermöglicht eine einfache Verwaltung von Datenversionen.

Vergleich mit Data Warehouse und Data Lake

Data Warehouses sind darauf ausgelegt, strukturierte Daten in festen Schemas zu speichern und bieten leistungsstarke Abfragefunktionen für Business Intelligence und Reporting. Sie sind ideal für Unternehmen, die konsistente, strukturierte Daten benötigen, um historische Analysen und Berichte zu erstellen. Allerdings können sie teuer und weniger flexibel sein, wenn es um die Speicherung und Verarbeitung unstrukturierter Daten geht.

Data Lakehouses hingegen nutzen kostengünstige Object Storage Services wie Amazon S3 oder Azure Blob Storage. Dieses Merkmal wurde von Data Lakes übernommen, jedoch lassen sich mit den oben genannten Speicherformaten auch strukturierte Daten darin ablegen. Eine solche Speicherlösung bieten eine nahezu unbegrenzte Skalierbarkeit und Flexibilität, was es ermöglicht, große Datenmengen zu speichern, ohne sich um die Infrastruktur kümmern zu müssen. Die Nutzung von Object Storage reduziert nicht nur die Kosten für die Datenspeicherung, sondern ermöglicht es, Daten aus verschiedenen Quellen zu integrieren und mit modernen Analysewerkzeugen zu verarbeiten, was besonders für datenintensive Anwendungen wie maschinelles Lernen und Echtzeitanalysen vorteilhaft ist.

Im Gegensatz zu klassischen Data Warehouses lassen sich in einem Data Lakehouse Datenspeicherung und -verarbeitung unabhängig voneinander skalieren. Insbesondere durch eine zeitnahe und bedarfsgerechte Bereitstellung von Rechenkapazitäten können die Vorteile der Cloud effektiv genutzt werden. Sehr große Datenmengen können somit in kürzerer Zeit verarbeiten werden. Umgekehrt führt eine unkomplizierte Freigabe dieser Ressourcen zur Kostenersparnis in Zeiten geringeren Bedarfs.

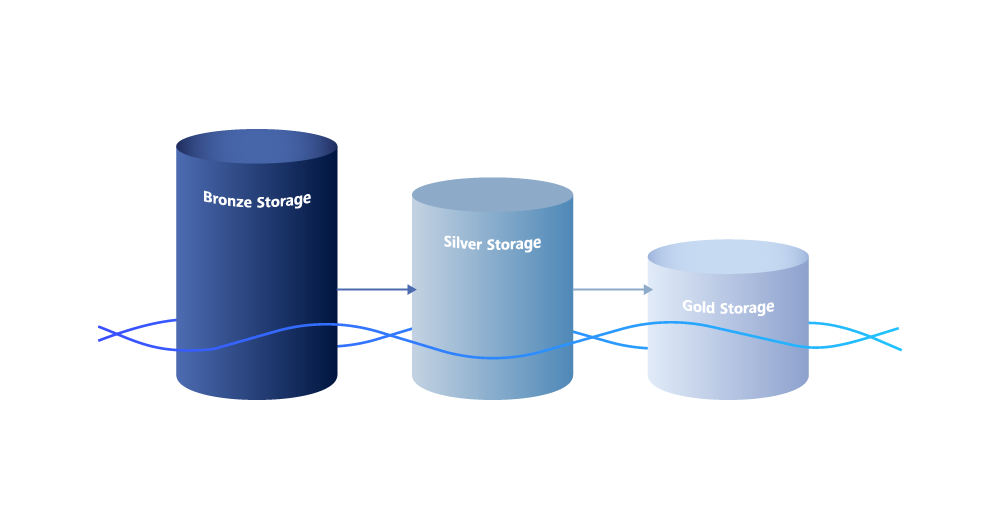

Bronze Stage der Medaillionarchitektur

Die Medaillonarchitektur in Datenplattformen ist ein Ansatz, bei dem Daten in mehreren Schichten organisiert werden, um ihre Qualität und Verwendbarkeit schrittweise zu verbessern. Diese Schichten umfassen die Bronze-Schicht für Rohdaten, die Silber-Schicht für bereinigte Daten, bei denen fehlerhafte, unvollständige oder inkonsistente Daten korrigiert oder entfernt werden, und die Gold-Schicht für angereicherte Daten, die durch Hinzufügen zusätzlicher Informationen oder durch Aggregation weiter verfeinert wurden. Dadurch wird eine strukturierte und effiziente Datenverarbeitung ermöglicht.

Ein wichtiger Aspekt der Datenspeicherung in einem Data Lakehouse ist die Bronze Stage der Medaillionarchitektur. In dieser Phase erfolgt die erste Aufnahme der Daten, die aus verschiedenen Quellen stammen (s. Arten von Datenquellen). Die Daten werden in ihrem Rohformat gespeichert, was bedeutet, dass sie noch nicht bereinigt oder transformiert wurden. Diese Bronze Stage dient als zentrale Ablage für alle eingehenden Daten und ermöglicht es Unternehmen, eine vollständige Historie ihrer Daten zu bewahren.

Die Bronze Stage ist entscheidend für die Data Ingestion, da sie die Grundlage für die nachfolgenden Stufen (Silber und Gold) bildet, in denen die Daten weiterverarbeitet, angereichert und für Analysen optimiert werden. Durch die Speicherung in der Bronze-Stufe haben Unternehmen jederzeit Zugriff auf die ursprünglichen Daten. Dies ist besonders wichtig für Audits, da es Transparenz und Nachvollziehbarkeit gewährleistet. Für Datenanalysen bietet der Zugriff auf die Rohdaten die Flexibilität, neue Analysemethoden zu testen oder bestehende Analysen zu validieren, indem man auf die ursprünglichen Daten zurückgreift.

Fazit

Data Ingestion ist ein zentraler Bestandteil industrieller Datenplattformen, der es ermöglicht, Daten aus verschiedenen Quellen effizient zu sammeln und für die Analyse zu speichern. In der Fertigungsindustrie ist dies besonders wichtig, da große Datenmengen in Echtzeit verarbeitet werden müssen, um Produktionsprozesse zu optimieren. Dabei bietet die Speicherung von Daten in einem Data Lakehouse unter Verwendung effizienter Formate wie Parquet, Delta Lake oder Apache Iceberg in kostengünstigen Cloud Object Storage Services zahlreiche Vorteile. Durch die Implementierung einer Medaillionarchitektur mit einer klaren Bronze Stage für die Data Ingestion können Unternehmen sicherstellen, dass sie eine robuste und flexible Dateninfrastruktur aufbauen, die ihnen hilft, wertvolle Einblicke aus ihren Daten zu gewinnen und ihre Produktionsprozesse zu optimieren.

Entscheidend für den Erfolg ist, dass sich die Implementierung einer Datenplattform an konkreten Anwendungsfällen orientiert. Denn nur die Nutzung der Daten schafft schließlich die erfolgsversprechenden Mehrwerte. Genau diese Anwendungsfälle sind das beste Indiz dafür, mit welchen Schritten begonnen werden sollte. So ist es ratsam diese z.B. nach schnellem Return on Investment (ROI) oder Quick Wins zu priorisieren. Es ist nicht notwendig gleich zu Beginn alle Elemente der Datenplattform zu implementieren, sondern diese Infrastruktur in einer sinnvollen Reihenfolge wachsen zu lassen.

Dieser Beitrag wurde verfasst von:

Christian Heinemann

Christian Heinemann ist Diplom-Informatiker und arbeitet als Solution Architect bei der ZEISS Digital Innovation am Standort Leipzig. Seine Arbeitsschwerpunkte liegen in den Bereichen verteilte Systeme, Cloud-Technologien und Digitalisierung im Bereich Manufacturing. Christian verfügt über mehr als 20 Jahre Projekterfahrung in der Softwareentwicklung. Er arbeitet mit verschiedenen ZEISS-Einheiten sowie externen Kunden zusammen, um innovative Lösungen zu entwickeln und umzusetzen.